Tanh函数也算式比较常见的激励函数了,在后面学习循环神经网络RNN(recurret neural networks)的时候我们就会接触到了.

Tanh函数也叫双曲正切函数,表达式如下:

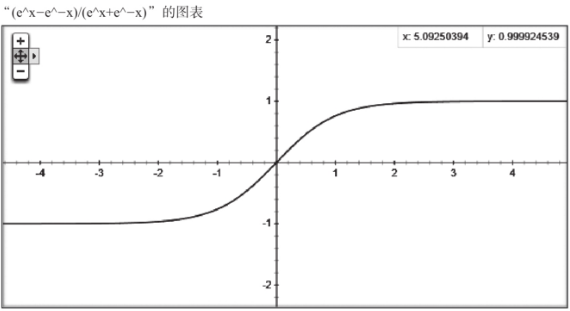

函数曲线是这样一个形式:

大家可以看到,Tanh函数跟Sigmoid函数长相很相近,都是一条S型曲线.只不过Tanh函数是把输入值投射到-1和1上去,其中-1表示完全不激活,1表示完全激活,中间其他值也是不同的激活程度的描述.除了映射区间不同以外,跟Sigmoid似乎区别不大.从x和y的关系来看,sigmoid函数在|x|>4之后的曲线就非常平缓的贴近0或1,Tanh函数在|x|>2之后会让曲线非常平缓的贴近-1或1

,这多多少少会影响一些训练过程中待定系数的收敛问题,其他的影响单纯从激励函数本身的特性来说还看不出来.