ReLU函数是目前大部分卷积神经网络CNN(convolutional neural networks)中喜欢使用的激励函数,他的全名是rectified linear units.

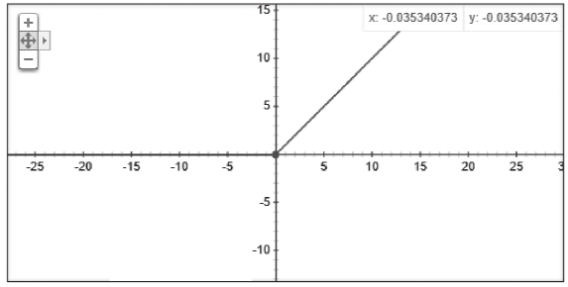

这个函数的形式为y=max(x,0),在这个函数的原点左侧部分斜率为0,在右侧则是一条斜率为1的直线.从样子上来看,这显然是非线性函数,x小于0时输出一律为0,x大于0的时候输出就是输入值

这个函数在刚刚我们看过的几个函数图像中看上去最有棱角,最明朗.人有古怪必有古怪能–这个函数还真是有一些非常优秀的特性,所以才会让大家在很多网络里都会倾向于使用他.