2016年3月,随着google的alphaGo战胜李世石,围棋–这一人类一直认为可以在长时间内轻松碾压AI的竞技领域已然无法固守,而深度学习(deep learning)这一象征着未来人工智能领域最重要,最核心的科技也越来越成为人们关注的焦点.

这里所谓的深度学习实际指的是基于深度神经网络(deep neural networks,DNN)的学习,也就是深度人工神经网络所进行的学习过程,或称作Deep Learn.这个deep指的是神经网络的深度(层数多).当然,其实业界没有特别具体的定义,大于多少层的算深度网络,少于多少层不算.没有这样一个说法.所以在这里我也就不强调多深算深的概念了,我们就权且管超过2层的–也就是1个隐藏层和1个输出层以上深度的都叫深度神经网络好了.不过,深度学习这个词我觉得还有另外一个层面的意思,就是说用这样一个网络可以学到很多深层次的东西,能够提取到很多用纯粹统计学指标,传统机器学习或显式的特征与内容描述无法名状的东西.机器能够学习到比较丰富的信息,这是人类在发明出计算机以后一直都在尝试挑战的一个领域.

就拿我们前面说过的例子来看,(年龄,身高,体重,血压,血脂)这样的数据向量必须由人提取,整理并明确每个向量纬度的确实含义.剩下的过程就是基于这些人类已经抽象过的指标来寻找他们之间的逻辑关系.这就是与”深度学习”相对的”浅度学习”的工作场景

如果使用贝叶斯概率进行学习,那就是用统计的方法解释不同事件先验概率和后验概率的量化关系计算问题;如果使用决策树归纳一个分类模型,那就是用纬度的引入把分类模型向信息熵降低的方向做引导,还是一个统计过程;如果是用支持向量机SVM做分类,那就是寻找超平面来保证分类的置信度最大,也就是让样本点距离超平面尽可能远,仍然是一个统计过程;这些问题大部分靠线性模型或者统计学概率模型能够给出清晰的物理含义解释,当然他们的局限性也非常明显.

很多人有一个误区,会认为深度学习在任何情况下都要比传统机器学习表现的更好,但实际上并不是这样.其实想想也知道,这不符合”尺有所短,寸有所长”的哲学观点.从前面的叙述可以看出,传统机器学习在工作的过程中具有非常好的解释特性,或者说你知道模型在做什么,处理的是什么特征,其中任何一个指标值的大小变化的意义会有良好的解释.而且传统机器学习在训练的过程中需要很少的样本向量,通常都是百级或者千级就够了,这对于深度学习来说也是无法做到的–他需要数以万计的样本来做训练.所以,大家千万不要盲目迷信深度学习的能力,也不要误读了深度学习的作用.

人类的眼睛,耳朵,口舌都是敏感和细腻的感知器官,这些领域的数据大多属于特征提取比较困难,数据量大,而且没办法通过线性关系或者统计概率关系直接描述.这些信息蕴含的分类规则对于只会做加减乘除,比大小和读写数据的计算器来说显得太困难了.他看到的不过是一堆数值而已,没有办法比较.

遗憾的是,这种非离散的数据信息是远比我们前面例子所指出的病患体检指标的数据难于量化.因为,我们量化存储的这些数据的信息都是关于屏幕上某个点的颜色,而这是极难与其实际承载的内容发生关联,更别说还要进行相应统计和概率计算了.

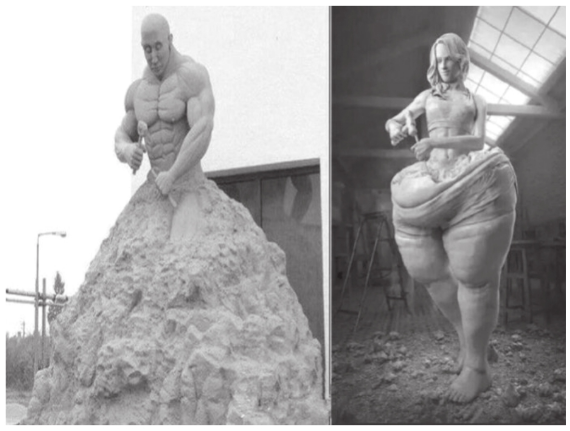

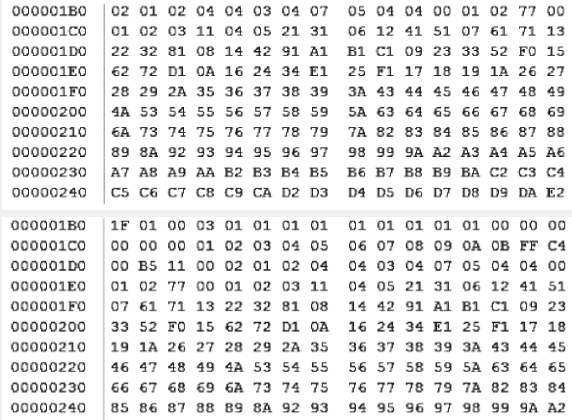

比如下面这两张图片,我们觉得两幅雕塑表示的内容主题是相似的,但是承载他的文件你用肉眼再怎么仔细看,也无法看出这堆数据之间的关系,不仅如此,即便你用其他任何一种常规性的机器学习算法,你也无法把这两个雕塑关联在一起,因为他们看上去是如此不相似

在我们连图片说承载的内容信心是不是相似都无法判断的情况下,显然是没有办法做更深一步的分析的,在我们束手无策的时候,出现了一类神器一般的算法逻辑系统,这就是我们刚才所说的神经网络,尤其是层级比较深的神经网络.

深度学习(deep learning)这个概念最早是由著名计算机科学家Geoffrey Hinton等人与2006年和2007年在科学杂志上发表的文章中所提出的,就深度学习而言,在最初被提出的时候指的是深度神经网络,而随着神经网络层数的增多,网络具备了很多原先非深度神经网络所不具备的学习能力,在设计合理的情况下,他能学到很多层面的内容,显得更为智能,也正是因为这一点,他使我们人类感觉到他学习层面的深度.还是那句话,虽然深度学习这个词本身单指网络的深度,但是如果你认为他指的是学习层面有深度,我觉得同样不能算错,因为他真的是这样,你在后面就会看到他有多么强大了.